當前,Token 的消耗量呈現出年均百倍增長的態勢。國家數據局統計顯示,截至今年6月底,我國日均Token消耗量從2024年初的1000億,已經突破至30萬億,1年半時間增長了300多倍。

隨著以DeepSeek、Ernie 為代表的 MoE 類推理模型爆火,大規模分布式推理系統的建設成了支持 AI 落地的挑戰。推理成本、推理效率、推理穩定性,正在取代參數規模,成為決定AI商業化上限的關鍵變量。

圍繞這一新的行業挑戰,在12月14日由百度百舸與SGLang社區聯合主辦的技術分享活動上,百度百舸將自己在生產系統上的最新實踐成果,SGLang將業界最新成果和動態,做了一次系統性分享。

百度百舸持續開源生產級代碼,聯合 SGLang 社區打造先進 AI Infra

在活動開場致辭中,百度智能云AI計算首席科學家王雁鵬明確表示:百度百舸正在將生產級代碼持續開源到開源社區。百度在大規模生產環境中積累的大模型訓推系統的各種能力,包括經過大規模系統打磨過的高度穩定的、高度優化的各種核心組件,都將逐一向行業分享。

同時,王雁鵬強調,開源并非一時的決定,而是百度堅信的技術方向和演進路徑。未來,百度會持續聯合各個社區,以開源的力量推動行業共同成長。

(百度智能云AI計算首席科學家王雁鵬)

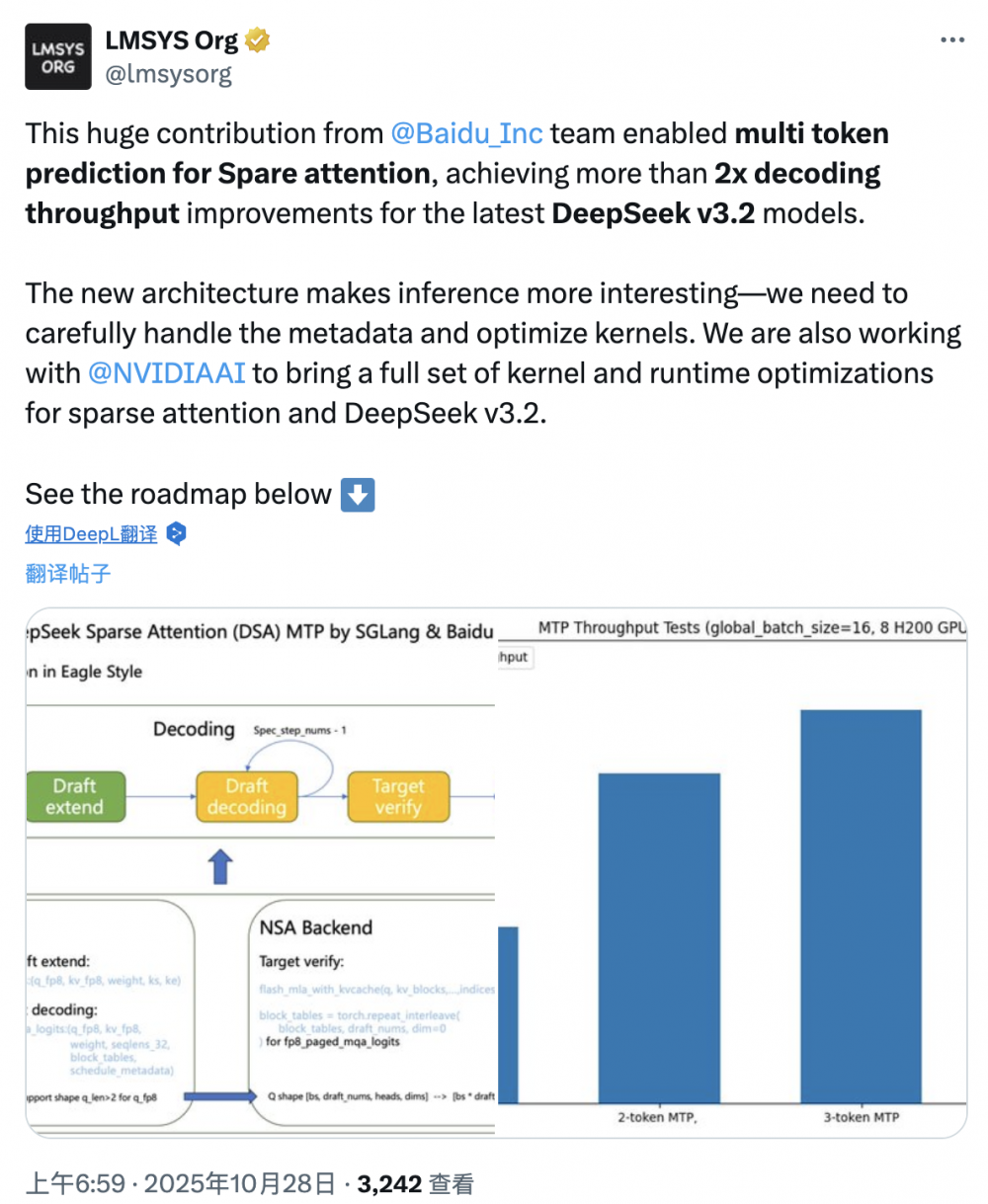

作為大模型時代崛起的重要開源項目之一的SGLang,百度智能云10月份攜手SGLang社區,將一套針對DeepSeek-V3.2推理性能優化的 MTP(Multi-Token Prediction,多token預測)技術代碼正式開源。SGLang 社區表示這是一項巨大的貢獻,社區實測顯示,采用這套技術,DeepSeek-V3.2模型解碼吞吐量能提升超過2倍。

在王雁鵬看來,推理引擎正變得越來越重要。智能經濟時代,推理引擎消耗的算力,將成為最核心的生產資料。如果推理成本做不到足夠低,身處大模型產業鏈上的玩家,就將失去競爭力,難以獲取Scaling的效益。

在本次 Meetup 中,百度百舸團隊圍繞如何建設大規模分布式推理基礎設施、DeepSeek V3.2 推理引擎等方面展開了系統性分享。

百度主任架構師田健重點介紹了百度百舸在大規模分布式推理集群基礎設施上的實踐。

隨著大模型到達千億、萬億規模的時代,其推理的部署也遇到了“不可能三角”的挑戰,需要在模型規模指數級增長、部署效率與穩定性和資源成本與彈性之間,尋求新的平衡。

百度百舸新一代大規模分布式推理基礎設施,以三大核心支柱破解大模型部署困局:通過自動化編排將分布式實例“原子化”,大幅簡化跨節點管理復雜度;創新“靜默實例”技術實現秒級資源激活,靈活應對潮汐流量;依托高性能流量調度與“班車調度”算法,極致壓榨集群性能。

百度高級架構師劉偉分享了百度百舸基于萬卡級生產系統實戰經驗,面向DeepSeek V3.2在推理引擎層面做的深度優化工作:通過輕量級CP讓長文本推理的TTFT近乎線性降低,更創新研發ESS系統破解長文本推理的顯存墻困境。

面對DeepSeek V3等MoE模型部署中FFN計算密度不足、GPU利用率低的痛點,百度高級工程師劉國維帶來了百度百舸在DeepSeek V3系列模型上的AE分離框架實戰,展示了在復雜并行與分離架構下,百度百舸如何在性能、穩定性與運維復雜度之間取得工程平衡。

SGLang 社區:推理框架的邊界正在被不斷拓展

來自SGLang 社區的 5 位開發者分享 了4 個業內最新進展,展現了 SGLang 社區在行業最前沿的動態。

SGLang 核心開發者張懿帶來了SGLang在Linear Model優化與Diffusion支持上的最新進展。

隨著長序列推理場景等的普及,傳統KV Cache管理方式面臨挑戰。SGLang 在內存管理、投機推理適配等方面進行了大量工程優化,使推理框架能夠更好地適配新一代模型結構。

在此基礎上,面向DeepSeek等主流模型所指向的統一模型技術迭代路線,SGLang也在嘗試從語言模型走向統一生成引擎。11月上線的SGLang Diffusion,便對外釋放了一個強烈信號,即SGLang的目標并不是一個LLM引擎,而是統一推理執行層。

來自SGLang Diffusionteam的范舒翼、陳茜,系統介紹了面向圖像與視頻生成的高性能推理引擎 SGLang Diffusion。在圖像與視頻生成場景中,SGLang Diffusion通過Pipeline組合、并行策略與Kernel復用,將Diffusion推理性能整體拉升到Diffusers的2–6倍區間,為未來DeepSeek等“理解+生成”統一模型的問世,預留了系統優化空間。

在推理加速方向,SGLang開發者李升桂帶來了SpecForge項目,解決了投機推理在真實系統中落地難、穩定性差的問題,讓這一理論上成熟的方法,真正具備工程可用性。

同時,來自SGLang RL Team成員李冀,也展示了SGLang在強化學習場景下的最新進展,進一步拓展了推理框架的適用邊界。

隨著大模型發展重心從訓練范式加速轉向推理范式,Token消耗需求呈現出遠超以往的增長曲線。百度將持續聯合開源社區,打造行業領先的AI Infra,不斷逼近推理系統的上限,持續滿足行業對Token消耗年增百倍的訴求。