自 2024 年起,大模型研發重心逐步從單純的預訓練轉向高質量的推理。如今,模型不僅要“會看”,更要“會想”。以 OpenAI 的 o1 為代表的一批推理模型,通過多步推理顯著降低錯誤率,宣告了“推理時代”的到來。2025 年初,DeepSeek 的問世將這一趨勢進一步放大。DeepSeek 通過多項工程與算法創新——包括 MOE(多專家并行)、多 pipeline 流水線掩蓋,以及 MLA(Multi-head Latent Attention)低秩壓縮以降低 KVcache 數據量——有效緩解了大規模推理的瓶頸,顯著提升訓練與推理性能,降低使用成本,從而成為普適大模型的典型代表。

在 RAG 等技術的推動下,推理正朝長序列輸入方向演進;與此同時,從事單純預訓練的廠商數量明顯減少,行業競爭焦點正在向“高效、低成本的推理能力”聚攏。誰能在最短時間內以最低成本獲得更高的推理收益,誰就能掌握智算市場的“屠龍刀”,贏得更大的市場與利潤空間。AI 的未來將由推理驅動,而推理的勝負,取決于誰能把性能做到極致并把成本壓到最低。把握這一點,就是把握未來智算市場的話語權。

AI集群推理對算力基礎設施的要求

提到推理的基礎設施,就不得不提Prefill與Deocde分離部署方式,我們先來了解下什么是prefill和decode。

● Prefill(預填充)階段:處理用戶的全部輸入,將相關信息寫入 KV cache,并生成第一個 token。每個推理任務中,Prefill 只執行一次。

● Decode(解碼)階段:以自回歸方式逐步生成后續 token。舉例:若輸出序列長度為 1024,則 Prefill 產生第 1 個 token,Decode 需執行剩余的 1023 次生成操作。

Prefill階段的特征是計算密集(Compute bound)型 ,需要遍歷模型所有層進行前向計算,大量矩陣乘法使得算術強度(FLOP/Byte)很高。GPU/加速卡的算力利用率通常可達 80%–90%,而 HBM(片上高帶寬內存)訪問相對較少,帶寬利用率僅為個位數百分比,帶寬并不是瓶頸。因此可通過減少 HBM 帶寬或容量,采用更低成本的 HBM 來降低總體成本。

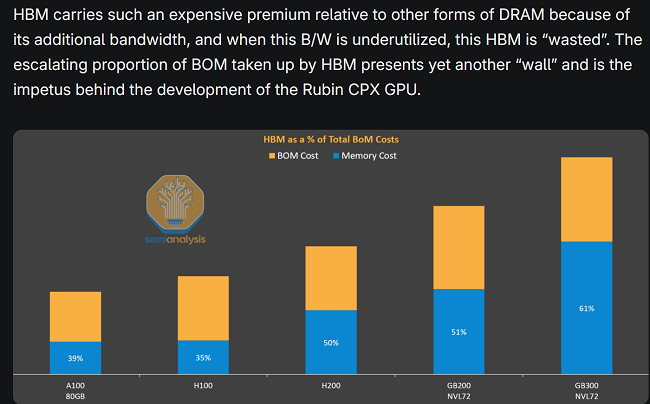

Semianalysis 對HBM的成本有詳細的分析,如下圖1所示:在NVL72的GB300中,HBM成本占比高達61%,在計算密集型的prefill階段,HBM有大量的時間都處于空閑狀態,這是對昂貴的HBM的資源極大浪費!

圖1 : HBM成本占比

而Decode階段的特征是訪存密集(memory bound)型,每生成一個 token 都需從 HBM 拉回 KV(通常為幾十 MB)到芯片處理單元(SM),帶寬利用率可達 70%–90%。Decode 階段頻繁進行 batch 組建與 KVcache/參數讀取,因此訪存帶寬直接決定了延遲與吞吐,成為關鍵性能瓶頸。

因此,在實際部署中,將 Prefill 和 Decode 分別放到不同類型的硬件節點(例如“算力節點”與“帶寬節點”)可以顯著提升整體吞吐并降低延遲;算力節點(Compute optimized):為 Prefill 提供高 FLOPS、較低 HBM 要求的硬件配置,降低成本。帶寬節點(Memory optimized):為 Decode 提供大帶寬、高容量的 HBM,消除訪存瓶頸,提升單 token延遲和吞吐。 下圖2為微軟&華盛頓大學研究成果,通過PD分離,實現推理性能的大幅提升(吞吐提升240%),而成本基本上沒有變化。

圖2 : 微軟&華盛頓大學PD分離部署研究結果

英偉達 Rubin CPX:為 Prefill 而生,推理成本迎來新拐點

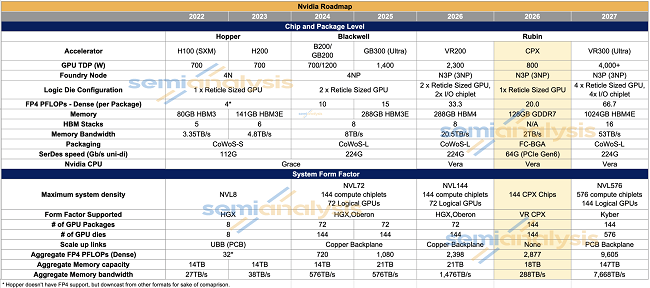

2025年9月9日,在英偉達 AI 基礎設施峰會上,英偉達推出了一款專為 Prefill 階段設計的 GPU——Rubin CPX。英偉達超大規模與高性能計算副總裁 Ian Buck 在發布會上進行了介紹(官方活動頁:https://www.nvidia.com/en-us/events/ai-infra-summit/),Rubin CPX 面向的是日益增長的長輸入序列場景,英偉達計劃于 2026 年底將其推向市場。下圖3是Rubin CPX與英偉達主流算力卡的對比,針對 Prefill 階段的特點(計算密集、帶寬需求低),Rubin CPX 做出了幾項調整:FP4 峰值算力約 20P,約為 R200 的 2/3 左右,將昂貴的 HBM 替換為更低成本的 GDDR7,顯存從 288GB 縮減到 128GB。

圖3:英偉達不同系列GPU芯片對比

其中變化最為明顯的是顯存的類型發生了變化,我們在前面章節提到,prefill階段是計算密集型的,訪存的次數比較少,使用昂貴的HBM會造成資源的閑置浪費,通過將顯存切換為價格更為便宜的GDDR,降低訪存帶寬,進一步降低了prefill階段的硬件成本,而性能基本不會有損失。除了顯存替換外,CPX 還取消了 NVLink 和 NVSwitch 等用于大規模 scale up 的互聯硬件,從而進一步壓縮了擴展成本。

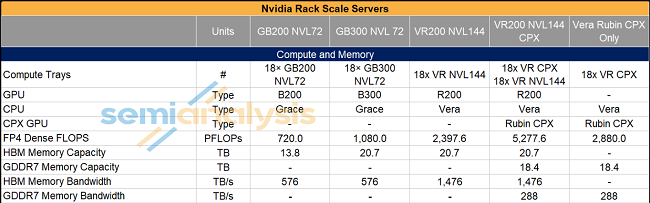

Rubin CPX 提供兩種機框配置形式(圖4):單框 144 個 CPX,以及 144 個 CPX 與 72 個 R200 組合同框。在這些配置中,CPX 更依賴于 scale out(橫向擴展)網絡來連接各個芯片,而不是傳統的高成本 scale up 互聯。

圖4:英偉達機架服務器介紹

這意味著在未來的推理集群架構中,低成本的 scale out 網絡將變得愈發重要:通過橫向擴展并結合合理的調度策略,能在保持吞吐的同時壓低總體擁有成本(TCO)。

與 Rubin CPX 同路:昇騰950PR 的算力帶寬平衡策略

在華為全聯接大會 2025 上,徐直軍發布了 Ascend 950PR/950DT 以及 Ascend 960、970 系列產品。其中,Ascend 950PR 是專為 Prefill 階段設計的算力卡,其設計思路與英偉達的 Rubin CPX 非常接近——通過有針對性的資源配比來降低 Prefill 的硬件成本。相較于面向更廣泛場景的 950DT(HBM 帶寬 4 TB/s),950PR 將顯存帶寬降至 1.6 TB/s,HBM 容量從 144 GB 縮減到 128 GB,進一步降低了Prefill階段的成本。未來,通過scale-out網絡連接950PR服務器形態,組成Prefill集群,進一步降低scale-up互聯成本,會是一個比較好的選擇。

圖5:華為發布昇騰950系列產品

異構算力是未來趨勢,推動scale-out網絡升級

昇騰 950PR 與英偉達 Rubin CPX 在思路上高度一致——在 Prefill 場景下犧牲部分帶寬和顯存容量,換取更低的硬件成本與更高的性價比。由此可見,按推理階段選用不同算力卡已成為明顯趨勢——例如將 CPX/950PR 用于 Prefill階段,把 R200/950DT 或 Cloud Matrix 384 用于 Decode階段。

實際上,某大型互聯網公司已經實現異構算力部署:用 NVIDIA 卡構建 Prefill 資源池、用超節點(高帶寬實例)構建 Decode 資源池。Prefill 階段獲得高算力密度并降低擴展成本;Decode 階段依靠超節點提供低延遲和大帶寬,滿足對實時性(TPOT)越來越苛刻的要求。華為云的研究論文也給出相似方案(如圖6):用昇騰 A2服務器 做 Prefill、昇騰CloudMatrix384超節點做 Decode,以在推理場景中實現更優的性價比。

圖6:《 xDeepServe: Model-as-a-Service on Huawei CloudMatrix384》

當前英偉達在算力上仍然領先,但國產 XPU(如昇騰、寒武紀、摩爾線程)正在快速崛起,形成百花齊放的格局。不同算力卡各擅所長,組合異構節點可以在成本與性能間取得更好平衡。在這種架構下(圖7),scale out 網絡需要承載大量 KV cache 和模型參數等流量,這對scale-out網絡也提出了新的要求:

(1)多種速率與接口兼容:需要支持 200G/400G/800G 接入,甚至同時承載存儲流量,未來可能還會復用 XPU 網卡以獲得更低延遲與更高帶寬。

(2) 無阻塞、高可靠的通信:異構算力間的通信模式復雜,網絡必須保證無阻塞通信,解決負載均衡、擁塞頭阻等問題,避免影響推理延遲與吞吐。

圖7:異構算力互聯架構